人体关键点检测

1.实验目的

学习检测摄像头拍摄到的画面中的人体关键点并通过画图提示。

2.核心代码

图像获取

pl=PipeLine(rgb888p_size=rgb888p_size,display_size=display_size,display_mode=display_mode)

img = pl.get_frame() # 拿到一个图像帧,供后续模型使用

使用 PipeLine 类获取一帧来自图像传感器(Camera)的图像。

图像的格式一般是 RGB888 planar,即三个通道数据独立存储(C, H, W)

图像预处理

self.ai2d.pad([0,0,0,0,top,bottom,left,right], 0, [0,0,0])

self.ai2d.resize(nn.interp_method.tf_bilinear, nn.interp_mode.half_pixel)

self.ai2d.build([1,3,ai2d_input_size[1],ai2d_input_size[0]],[1,3,self.model_input_size[1],self.model_input_size[0]])

用 Ai2D 对图像做 Padding + Resize,让它适配模型输入 [320, 320]。

保持纵横比缩放,填充剩余区域(letterbox padding)防止变形。

转换格式为 NCHW,且转换为 uint8 类型。

模型推理

res=person_kp.run(img)

继承自 AIBase,这个函数内部会执行:

- 把 RGB 图像送入 Ai2D 处理

- 推理模型

.kmodel - 获取结果(例如输出 shape 是

[1, 6, 56, 56]形式)

后处理

results = aidemo.person_kp_postprocess(results[0],[self.rgb888p_size[1],self.rgb888p_size[0]],self.model_input_size,self.confidence_threshold,self.nms_threshold)

从模型输出中提取出每个 关键点位置 (x, y) 和 置信度 score

执行 NMS(非极大值抑制)保留最优人体目标

将 keypoints 按原图坐标系进行反变换(去掉 padding 缩放影响)

结果格式为:

res[0] = 每个人的边界框信息

res[1] = 每个人的 17 个关键点信息,每个为 [x, y, score]

绘图显示

person_kp.draw_result(pl,res)

遍历每个人体目标:

- 画关键点(圆点)

- 按照

SKELETON定义,连成骨骼线(线段)

使用 osd_img 接口绘制(On Screen Display)

例如:

pl.osd_img.draw_circle(x, y, 半径, 颜色, 线宽)

pl.osd_img.draw_line(x1, y1, x2, y2, 颜色, 线宽)

3.示例代码

'''

本程序遵循GPL V3协议, 请遵循协议

实验平台: DshanPI CanMV

开发板文档站点 : https://eai.100ask.net/

百问网学习平台 : https://www.100ask.net

百问网官方B站 : https://space.bilibili.com/275908810

百问网官方淘宝 : https://100ask.taobao.com

'''

from libs.PipeLine import PipeLine, ScopedTiming # 图像采集和处理管道模块

from libs.AIBase import AIBase # AI 推理的基础类

from libs.AI2D import Ai2d # 图像预处理模块

import os

import ujson

from media.media import * # 媒体模块,获取图像帧等

from time import *

import nncase_runtime as nn # nncase 推理运行库

import ulab.numpy as np # Ulab 提供的 numpy 支持(轻量)

import time

import utime

import image

import random

import gc

import sys

import aidemo # 包含关键点后处理的工具包

# 自定义人体关键点检测类

class PersonKeyPointApp(AIBase):

def __init__(self,kmodel_path,model_input_size,confidence_threshold=0.2,nms_threshold=0.5,rgb888p_size=[1280,720],display_size=[1920,1080],debug_mode=0):

super().__init__(kmodel_path,model_input_size,rgb888p_size,debug_mode)

self.kmodel_path=kmodel_path

# 模型输入分辨率

self.model_input_size=model_input_size

# 置信度阈值设置

self.confidence_threshold=confidence_threshold

# nms阈值设置

self.nms_threshold=nms_threshold

# sensor给到AI的图像分辨率

self.rgb888p_size=[ALIGN_UP(rgb888p_size[0],16),rgb888p_size[1]]

# 显示分辨率

self.display_size=[ALIGN_UP(display_size[0],16),display_size[1]]

self.debug_mode=debug_mode

#骨骼信息

self.SKELETON = [(16, 14),(14, 12),(17, 15),(15, 13),(12, 13),(6, 12),(7, 13),(6, 7),(6, 8),(7, 9),(8, 10),(9, 11),(2, 3),(1, 2),(1, 3),(2, 4),(3, 5),(4, 6),(5, 7)]

#肢体颜色

self.LIMB_COLORS = [(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 255, 51, 255),(255, 255, 51, 255),(255, 255, 51, 255),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0)]

#关键点颜色,共17个

self.KPS_COLORS = [(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255)]

# Ai2d实例,用于实现模型预处理

self.ai2d=Ai2d(debug_mode)

# 设置Ai2d数据格式为 NCHW,数据类型�为 uint8

self.ai2d.set_ai2d_dtype(nn.ai2d_format.NCHW_FMT,nn.ai2d_format.NCHW_FMT,np.uint8, np.uint8)

# 配置预处理操作,这里使用了pad和resize,Ai2d支持crop/shift/pad/resize/affine,具体代码请打开/sdcard/app/libs/AI2D.py查看

def config_preprocess(self,input_image_size=None):

with ScopedTiming("set preprocess config",self.debug_mode > 0):

# 初始化ai2d预处理配置,默认为sensor给到AI的尺寸,您可以通过设置input_image_size自行修改输入尺寸

ai2d_input_size=input_image_size if input_image_size else self.rgb888p_size

top,bottom,left,right=self.get_padding_param()

self.ai2d.pad([0,0,0,0,top,bottom,left,right], 0, [0,0,0])

self.ai2d.resize(nn.interp_method.tf_bilinear, nn.interp_mode.half_pixel)

self.ai2d.build([1,3,ai2d_input_size[1],ai2d_input_size[0]],[1,3,self.model_input_size[1],self.model_input_size[0]])

# 自定义当前任务的后处理

def postprocess(self,results):

with ScopedTiming("postprocess",self.debug_mode > 0):

# 这里使用了aidemo库的person_kp_postprocess接口

results = aidemo.person_kp_postprocess(results[0],[self.rgb888p_size[1],self.rgb888p_size[0]],self.model_input_size,self.confidence_threshold,self.nms_threshold)

return results

#绘制结果,绘制人体关键点

def draw_result(self,pl,res):

with ScopedTiming("display_draw",self.debug_mode >0):

if res[0]:

pl.osd_img.clear()

kpses = res[1]

for i in range(len(res[0])):

for k in range(17+2):

if (k < 17):

kps_x,kps_y,kps_s = round(kpses[i][k][0]),round(kpses[i][k][1]),kpses[i][k][2]

kps_x1 = int(float(kps_x) * self.display_size[0] // self.rgb888p_size[0])

kps_y1 = int(float(kps_y) * self.display_size[1] // self.rgb888p_size[1])

if (kps_s > 0):

pl.osd_img.draw_circle(kps_x1,kps_y1,5,self.KPS_COLORS[k],4)

ske = self.SKELETON[k]

pos1_x,pos1_y= round(kpses[i][ske[0]-1][0]),round(kpses[i][ske[0]-1][1])

pos1_x_ = int(float(pos1_x) * self.display_size[0] // self.rgb888p_size[0])

pos1_y_ = int(float(pos1_y) * self.display_size[1] // self.rgb888p_size[1])

pos2_x,pos2_y = round(kpses[i][(ske[1] -1)][0]),round(kpses[i][(ske[1] -1)][1])

pos2_x_ = int(float(pos2_x) * self.display_size[0] // self.rgb888p_size[0])

pos2_y_ = int(float(pos2_y) * self.display_size[1] // self.rgb888p_size[1])

pos1_s,pos2_s = kpses[i][(ske[0] -1)][2],kpses[i][(ske[1] -1)][2]

if (pos1_s > 0.0 and pos2_s >0.0):

pl.osd_img.draw_line(pos1_x_,pos1_y_,pos2_x_,pos2_y_,self.LIMB_COLORS[k],4)

gc.collect()

else:

pl.osd_img.clear()

# 计算padding参数

def get_padding_param(self):

dst_w = self.model_input_size[0]

dst_h = self.model_input_size[1]

input_width = self.rgb888p_size[0]

input_high = self.rgb888p_size[1]

ratio_w = dst_w / input_width

ratio_h = dst_h / input_high

if ratio_w < ratio_h:

ratio = ratio_w

else:

ratio = ratio_h

new_w = (int)(ratio * input_width)

new_h = (int)(ratio * input_high)

dw = (dst_w - new_w) / 2

dh = (dst_h - new_h) / 2

top = int(round(dh - 0.1))

bottom = int(round(dh + 0.1))

left = int(round(dw - 0.1))

right = int(round(dw - 0.1))

return top, bottom, left, right

if __name__=="__main__":

# 显示模式,默认"hdmi",可以选择"hdmi"和"lcd"

display_mode="lcd"

# k230保持不变,k230d可调整为[640,360]

rgb888p_size = [1920, 1080]

if display_mode=="hdmi":

display_size=[1920,1080]

else:

display_size=[800,480]

# 模型路径

kmodel_path="/sdcard/examples/kmodel/yolov8n-pose.kmodel"

# 其它参数设置

confidence_threshold = 0.2

nms_threshold = 0.5

# 初始化PipeLine

pl=PipeLine(rgb888p_size=rgb888p_size,display_size=display_size,display_mode=display_mode)

pl.create()

# 初始化自定义人体关键点检测实例

person_kp=PersonKeyPointApp(kmodel_path,model_input_size=[320,320],confidence_threshold=confidence_threshold,nms_threshold=nms_threshold,rgb888p_size=rgb888p_size,display_size=display_size,debug_mode=0)

person_kp.config_preprocess()

try:

while True:

os.exitpoint()

with ScopedTiming("total",1):

# 获取当前帧数据

img=pl.get_frame()

# 推理当前帧

res=person_kp.run(img)

# 绘制结果到PipeLine的osd图像

person_kp.draw_result(pl,res)

# 显示当前的绘制结果

pl.show_image()

gc.collect()

except Exception as e:

sys.print_exception(e)

finally:

person_kp.deinit()

pl.destroy()

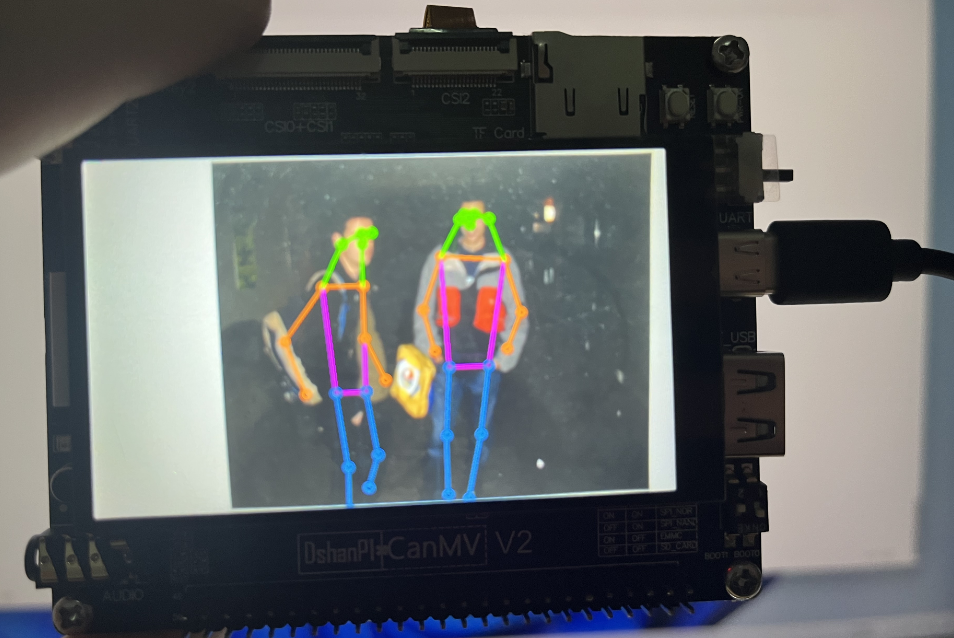

4.实验结果

点击运行代码后,可以在显示屏上看到人体关键点检测的结果。如下所示: